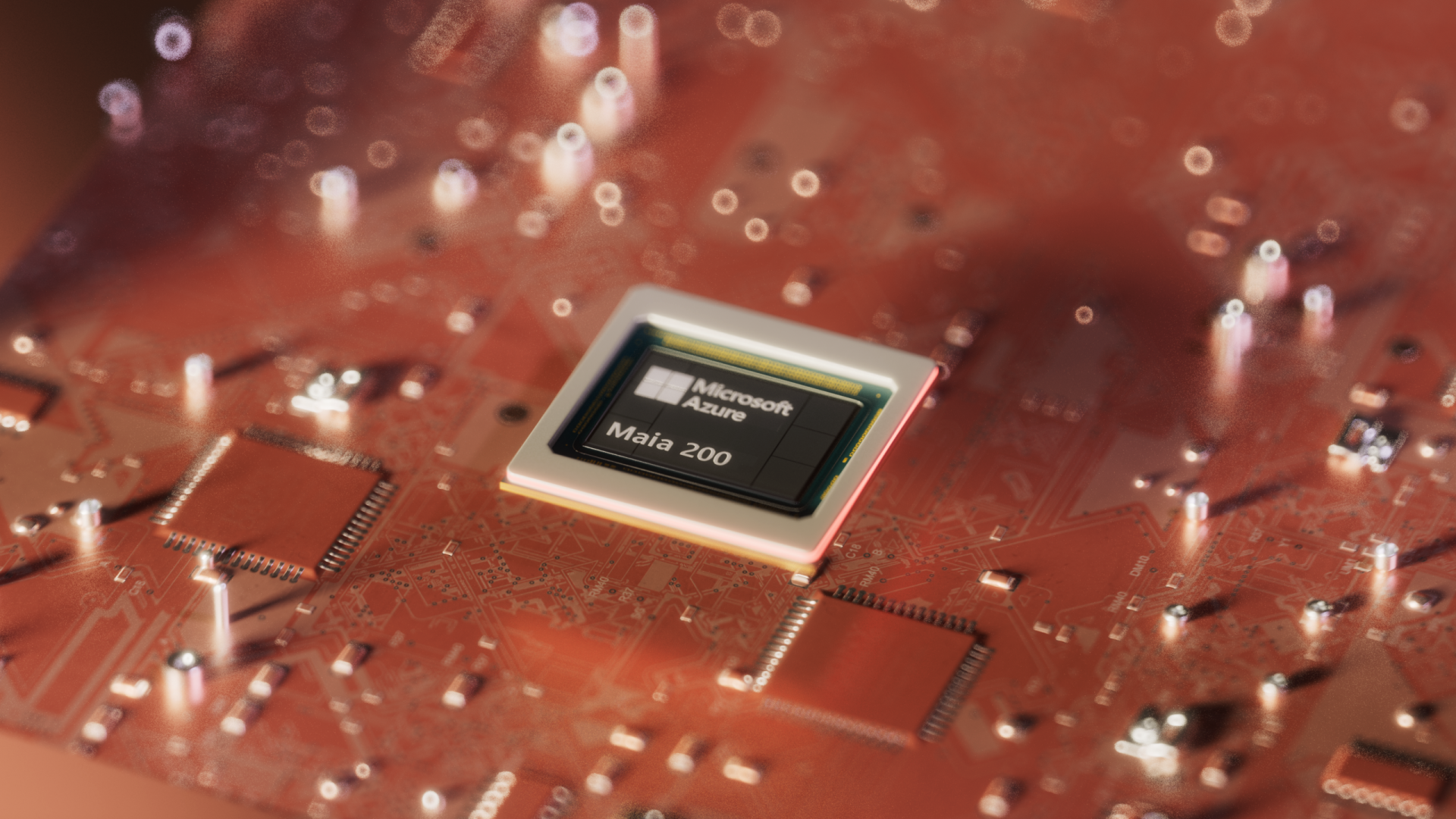

Microsoft annuncia Maia 200, un nuovo acceleratore di intelligenza artificiale progettato per rendere l’AI più veloce, più efficiente e più conveniente nell’uso di tutti i giorni.

Ecco i dettagli e le caratteristiche di Maia 200:

- Progettare l’intelligenza artificiale per funzionare in modo efficiente e scalabile negli scenari di utilizzo reale. Maia 200 rende l’AI più efficiente e accessibile, combinando modelli più intelligenti con un’infrastruttura avanzata. Progettato per l’inferenza — il momento in cui l’AI risponde a prompt, genera contenuti o supporta decisioni in tempo reale — rende l’AI più veloce, efficiente e conveniente su scala globale, garantendo prestazioni affidabili e sostenibili negli scenari di uso quotidiano

- L’inferenza è dove l’AI entra davvero in gioco. L’inferenza è il momento in cui l’AI fa davvero la differenza. Sebbene l’addestramento dei modelli riceva molta attenzione, la maggior parte dell’uso reale dei modelli avviene successivamente. Tradizionalmente si usava hardware per effettuare i training, potente ma costoso e poco efficiente. Maia 200 è la prima piattaforma di silicon e sistema progettata da Microsoft espressamente per l’inferenza AI, con l’obiettivo di migliorare in modo significativo costo, latenza ed efficienza energetica nell’esecuzione di modelli generativi e di reasoning su larga scala. Maia 200 è anche il sistema di inferenza più efficiente abbiamo mai implementato, con prestazioni per dollaro migliori del 30% rispetto all’hardware di ultima generazione.

- Progettato per funzionare concretamente, non solo in teoria. Maia 200 rende l’AI davvero utile, rispondendo in modo immediato, affidabile e su larga scala. Costruito con tecnologie avanzate e ottimizzato per i calcoli dei modelli AI, include un sistema di memoria e networking ridisegnato per mantenere i dati vicini e ridurre ritardi. I primi sistemi Maia 200 sono in fase di deployment nella regione Azure US Central, con estensione prevista ad altre regioni, tra cui US West 3, nei prossimi mesi.

- L’AI integrata nei prodotti che usiamo ogni giorno. Maia 200 supporterà una gamma di workload AI di Microsoft, inclusi la generazione di dati sintetici, il miglioramento avanzato dei modelli e le esperienze AI in Microsoft Foundry e Microsoft 365 Copilot. Nel tempo, supporterà anche workload più ampi dei clienti come parte della piattaforma cloud Microsoft. Riducendo costi e complessità nell’esecuzione dell’AI, Maia 200 contribuisce a garantire che le capacità avanzate di AI possano scalare in modo responsabile – senza aumentare il consumo energetico o l’overhead operativo.

- Dalla sperimentazione all’uso reale. Maia 200 mostra come il settore stia passando dalla sperimentazione all’infrastruttura, dalla novità alla necessità. Maia 200 non promette solo intelligenza, ma la rende utilizzabile, accessibile e pronta per la vita di tutti i giorni.

- La caratteristica distintiva di Maia 200 è la precisione e scalabilità. Maia 200 ottimizza l’uso di formati numerici ridotti, elaborando i workload AI in modo più efficiente, con meno energia, memoria e macchine. Un singolo sistema può eseguire i modelli più grandi attuali con margine, riducendo il numero di chip necessari e il costo per risposta. Realizzato con il processo all’avanguardia a 3 nanometri di TSMC, ogni chip Maia 200 contiene oltre 140 miliardi di transistor ed è pensato per carichi di lavoro AI su larga scala